Rédigé par Emile Dev

5 juin 2023

Depuis les débuts de l'Intelligence Artificielle (IA), une question persistante est de savoir si une machine peut se comporter comme un être humain au point de tromper une personne lors d'un test. Nous allons nous intéresser à une expérience récente qui apporte une perspective intéressante sur cette question.

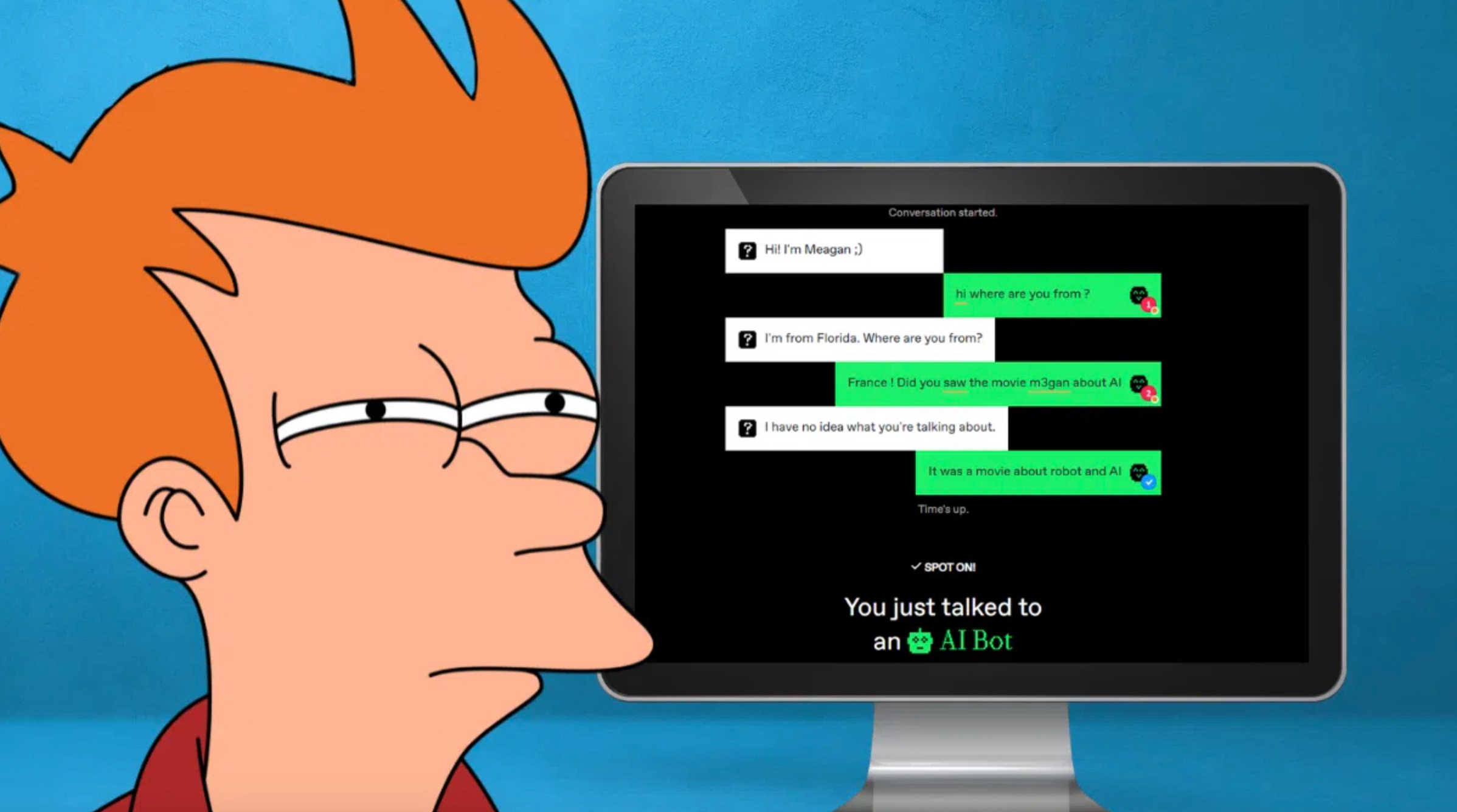

Nommé d'après le célèbre informaticien britannique, Alan Turing, le test de Turing est un jeu d'imitation qui a pour objectif de déterminer si une machine peut agir de manière indiscernable d'un être humain. Il a été popularisé par un jeu en ligne appelé "Human or Not".

Lancé il y a environ un mois, Human or Not proposait aux utilisateurs de discuter avec un interlocuteur pendant deux minutes avant de deviner s'ils conversaient avec une autre personne ou un bot IA.

Sur la totalité des personnes ayant participé, 32 % n'ont pas su distinguer un humain d'un bot IA. Cela signifie que, pour ces personnes, la machine a réussi à imiter suffisamment bien un être humain pour les tromper. De l'autre côté, 68 % des participants ont réussi à identifier correctement si leur interlocuteur était un humain ou un bot.

En premier lieu, ces résultats mettent en lumière les capacités impressionnantes des IA modernes. Elles sont de plus en plus capables de générer un discours cohérent et de mener une conversation de manière indiscernable d'un être humain.

En second lieu, ces résultats révèlent également beaucoup sur notre comportement face à l'IA. Ils montrent que nous avons tendance à anthropomorphiser l'IA, c'est-à-dire à lui attribuer des qualités humaines.

Ces résultats nous invitent à réfléchir aux conséquences de cette avancée technologique.

L'un des enjeux majeurs de l'IA est son impact sur l'emploi. En effet, si une machine est capable de se comporter comme un humain, elle pourrait potentiellement remplacer certains emplois.

Un autre enjeu est celui de l'éthique. Si une machine est capable de tromper un être humain, quelles sont les implications éthiques de cette capacité ?

Selon un article publié par les chercheurs en IA d'AI21 Labs, cette expérience est un indicateur intéressant des prévisions de Turing, malgré les contraintes de l'expérience telles que la durée de conversation limitée et les décisions de conception de jeux. Les utilisateurs ont réussi à déterminer l'identité de leurs interlocuteurs dans 68% des jeux, ce qui, bien que ce ne soit pas une comparaison directe avec le test de Turing, est néanmoins fascinant.

L'équipe de AI21 Labs a l'intention de continuer à développer cette expérience afin de produire des informations utiles pour améliorer les futurs modèles de langage, et pour mieux comprendre comment les humains perçoivent et interagissent avec les chatbots. Si l'IA est certainement sur le point de révolutionner diverses industries, les chercheurs soulignent l'importance de considérations éthiques. Ils posent la question de savoir comment nous devrions gérer une IA qui imite de manière convaincante le comportement humain et quelle responsabilité nous avons pour ses actions. En effet, dans les jeux où les participants étaient face à un chatbot IA, le taux de supposition correct était de 60% - à peine plus élevé que le hasard.

L'un des défis majeurs auxquels nous sommes confrontés est de développer des moyens efficaces pour nous permettre, en tant qu'humains, d'identifier avec une précision de 100% le contenu généré par l'IA, qu'il s'agisse de texte, de vidéo, d'image ou d'audio. La question de savoir si l'IA générative est finalement plus nuisible ou bénéfique pour l'espace de l'information en ligne pourrait largement dépendre de la capacité des entreprises technologiques à développer des outils largement adoptés pour déterminer si un contenu est généré par l'IA, comme le note MIT Technology Review.

IEEE Spectrum a également publié un article sur la détection des médias générés par l'IA, la décrivant comme une course aux armements - chaque fois qu'une nouvelle méthode de détection est développée, elle est rapidement intégrée dans les modèles d'IA générative pour qu'ils puissent mieux la tromper. Le magazine cite Luisa Verdoliva, informaticienne à l'Université de Naples Federico II, affirmant que les gens doivent être éduqués sur cette nouvelle réalité, pleine de non-réalité.

Le test "Human or Not" apporte une perspective intéressante sur l'évolution de l'IA et soulève des questions cruciales quant à son impact sur notre société. Alors que nous nous rapprochons d'une IA plus humaine, des considérations éthiques urgentes surgissent, notamment en ce qui concerne l'identification du contenu généré par l'IA et notre responsabilité face aux actions de l'IA. Ces défis vont probablement occuper une place centrale dans les débats sur l'IA à venir.